Large Language Models (LLMs) wie die GPT-Serie von OpenAI sind gerade in aller Munde. Diese KI-Tools können auf der Grundlage der Daten, mit denen sie trainiert wurden, Text verstehen und generieren. Doch so verlockend es auch sein mag, diese Technologien direkt mit Ihren internen Geschäftsdaten zu integrieren, es gibt wichtige Schritte und Überlegungen, die nicht übersehen werden dürfen.

Was ist ein LLM und wie kann es Unternehmen helfen?

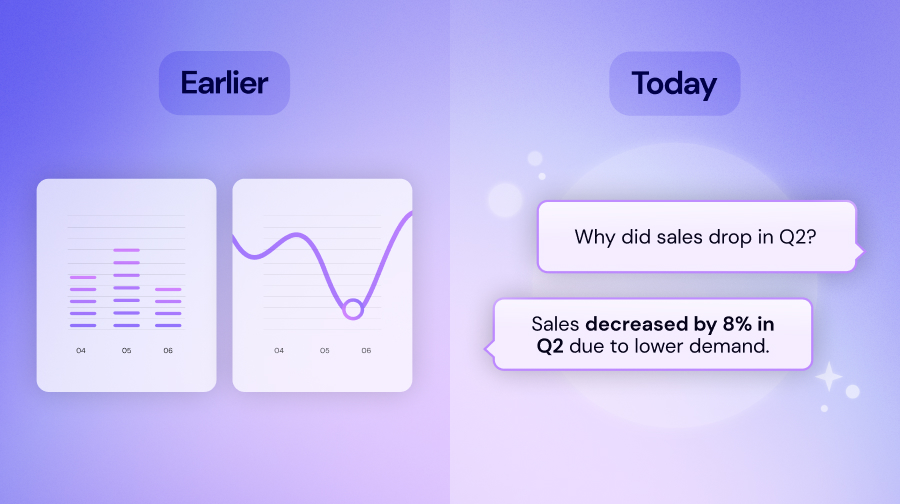

Ein LLM oder Large Language Model ist eine Art künstlicher Intelligenz, die sprachbasierte Ausgaben verarbeitet und generiert. Die Modelle werden anhand einer Vielzahl von Internetdaten trainiert. Infolgedessen können sie eine Vielzahl von Aufgaben ausführen, z. B. Fragen beantworten, Dokumente zusammenfassen, Inhalte generieren und sogar programmieren. Für Unternehmen liegt der Reiz von LLMs in ihrer Fähigkeit, komplexe Aufgaben zu automatisieren, für die traditionell menschliche Intelligenz erforderlich war. Dies spart potenziell Zeit und Ressourcen, und steigert somit Produktivität.

Kombination von LLMs mit unternehmensinternen Daten und Wissen

Durch die Integration eines LLM mit unternehmensspezifischen Daten und internen Wissensdatenbanken können seine Funktionen auf speziellere Aufgaben zugeschnitten werden, die für ein bestimmtes Unternehmen oder eine bestimmte Branche relevant sind. Ein LLM kann beispielsweise so angepasst werden, dass es technische Berichte versteht und erstellt, die für eine Branche wie bspw. die Pharmaindustrie spezifisch sind, oder um Kundendienstanfragen im Zusammenhang mit der Produktlinie eines Unternehmens zu bearbeiten. Diese Anpassung ermöglicht es Unternehmen, die Funktionen eines LLM so zu nutzen, dass sie direkt auf die spezifischen Bedürfnisse des Unternehmens abgestimmt sind.

Aber es gibt Einschränkungen

Die Idee, ein LLM mit internen Daten zu kombinieren, ist zwar vielversprechend, aber nicht so einfach, wie es scheint. Ein gängiger Ansatz zur Integration eines LLM mit bestimmten Datensätzen ist die Verwendung einer Technik namens Retrieval-Augmented Generation (RAG). RAG kombiniert einen Suchindex, über denrelevante Dokumente aus einer Wissensdatenbank abgerufen werden, und ein LLM, das Antworten auf der Grundlage der abgerufenen Informationen erstellt. Diese Methode hat jedoch Einschränkungen.

Erstens hängt die Qualität der Ergebnisse stark von der Relevanz und Qualität der abgerufenen Informationen ab. Wenn die zugrundeliegende Wissensbasis schlecht organisiert oder veraltet ist, können die Antworten des LLM ungenau oder irrelevant sein. Leider ist dies in der Realität fast immer der Fall, und nur kleine Unternehmen sind in der Regel in der Lage, all ihre internen Daten und ihr Wissen manuell zu strukturieren.

Zweitens ist es nicht möglich, das gesamte Wissen des Unternehmens in das LLM einzuspeisen, und selbst wenn dies möglich wäre, wäre das LLM nicht in der Lage, relevante von irrelevanten Informationen zu unterscheiden. Um die Relevanz zuverlässig zu bestimmen, müssen unterschiedliche Relevanzsignale wie bspw. Aktualität, Popularität oder die Informationsersteller bzw. -bearbeiter berücksichtigt werden.

Die Lösung ist ein Knowledge Graph für's Unternehmen

Um das Potenzial eines LLM effektiv für Ihr Unternehmen zu nutzen, ist es wichtig, einen Knowledge Graph zu erstellen. Ein Knowledge Graph organisiert und indexiert Daten anhand von Beziehungen. Er ist von Natur aus dynamisch, was bedeutet, dass er sich mit neuen Informationen weiterentwickeln kann. Diese Struktur hilft nicht nur beim besseren Abrufen von Daten, sondern ermöglicht es dem LLM auch, den Kontext effektiver zu verstehen.

Um einen umfassenden Knowledge Graph zu erstellen, müssen wichtige Datenpunkte und Beziehungen dargestellt werden, die für Ihr Unternehmen relevant sind. Dies verbessert nicht nur den Abrufmechanismus des LLM, indem es ihm einen reichhaltigen und gut strukturierten Datensatz zur Verfügung stellt, sondern verbessert auch die Genauigkeit und Relevanz der von ihm generierten Ergebnisse. Ohne einen solchen Rahmen riskieren Unternehmen, dass die Ergebnisse der internen KI schlecht sind, was zu Ineffizienzen, Halluzinationen und potenziell falschen Entscheidungen führt.

Fazit

LLMs bieten zwar erhebliche Vorteile, aber wenn Sie ohne angemessene Vorbereitung und Infrastruktur einfach eines auf Ihre Daten anwenden, kann dies zu suboptimalen Ergebnissen führen. Indem Sie die inhärenten Einschränkungen verstehen und in einen ausgeklügelten Knowledge Graph wie Zive investieren, können Sie Ihr Unternehmen besser positionieren und das transformative Potenzial von LLMs wirklich nutzen. Dieser strategische Ansatz stellt sicher, dass die Integration von LLMs nicht nur die betriebliche Effizienz verbessert, sondern auch zu nachhaltigen Innovationen und Wettbewerbsvorteilen führt.

.jpg)